Observability is het vermogen om de interne toestand van je systemen te begrijpen aan de hand van logs, metrics en traces.

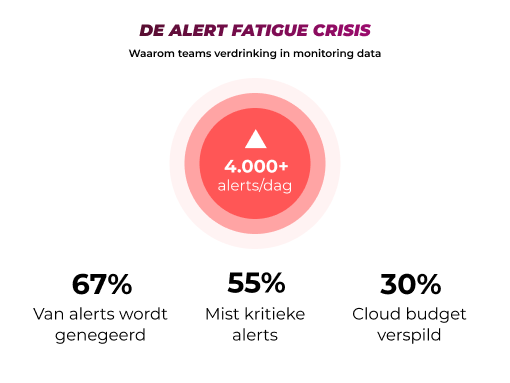

Organisaties ontvangen gemiddeld meer dan 4.000 alerts per dag, waarvan teams 67% negeert door false positives en ruis (LogicMonitor studie, 2025). Voor IT-managers betekent dit niet alleen dat kritieke problemen onopgemerkt blijven, maar ook dat cloud logging-kosten ongecontroleerd oplopen zonder bruikbare inzichten op te leveren. Tegelijk verspillen bedrijven gemiddeld 30% van hun cloud budget aan logging zonder strategie (CloudZero, 2024).

Deze blog toont hoe je strategisch observability opbouwt met focus op bruikbare metrics en dashboards die daadwerkelijk gebruikt worden, zonder je team te laten verdrinken in data. Filip V., DevOps consultant met jarenlange ervaring in het opzetten van observability-systemen voor enterprise klanten, legt uit hoe je de balans vindt tussen voldoende inzicht en haalbare monitoring.

Stap 1: Begrijp eerst wat monitoring versus observability echt betekent

Veel organisaties denken dat ze observability hebben als ze alleen logs verzamelen en een dashboard opzetten. Het verschil tussen klassieke monitoring en echte observability is fundamenteel: monitoring verzamelt data zonder context, terwijl observability methoden ontwikkelt om daadwerkelijk overzicht te krijgen van je volledige omgeving.

Filip legt uit: "Observability gaat over het ontwikkelen van methoden waarin je overzicht hebt van je omgeving, je solutions, je applicaties, je infrastructuur en uiteindelijk je volledige organisatie. Het probleem is dat organisaties vaak logging activeren zonder daarover na te denken. Het resultaat is een enorme datastroom die weinig tot geen bruikbare informatie oplevert en tegelijk hoge cloudkosten veroorzaakt."

Deze kostenfactor is niet hypothetisch. Bedrijven verspillen gemiddeld 30% van hun cloud budget aan ongecontroleerd loggen (CloudZero, 2024). In de cloud is het eenvoudig om miljoenen logrecords per uur weg te pompen. Microsoft, Amazon en Google verwerken dat met plezier, maar op het eind van de maand krijg je een dikke factuur. Slechts 30% van organisaties weet exact waar hun cloud budget naartoe gaat (CloudZero State of Cloud Cost Intelligence Report, 2024).

Het startpunt voor effectieve observability is het onderscheiden van twee pijlers: non-functional logs (infrastructuur en services) en functional logs (applicatie-gerelateerd). Beide vereisen een strategische aanpak, maar de methodiek verschilt. Bij infrastructuur monitor je resources zoals CPU en geheugen. Bij applicaties volg je businesslogica en gebruikersinteracties. De fout die veel teams maken is proberen alles tegelijk aan te pakken zonder eerst te begrijpen wat elke component doet en welke data daaruit relevant is.

Het verschil in aanpak komt neer op een simpel principe: niet alles loggen, maar strategisch bepalen wat je wilt weten en daar je logging op afstemmen. Dit voorkomt niet alleen kostenoverschrijdingen, maar zorgt er ook voor dat je team daadwerkelijk inzichten krijgt in plaats van te verdrinken in irrelevante data.

Stap 2: Begin met je infrastructuur-metrics in plaats van direct alles te willen monitoren

De verleiding is groot om direct alle mogelijke data te verzamelen. Een betere aanpak is starten met de basis: de resources die je applicaties hosten. Denk aan CPU-gebruik, geheugen, netwerkverkeer en opslagcapaciteit. Deze infrastructuur-metrics vormen de fundering van elk observability-systeem.

Filip benadrukt het belang van context: "Voor een archiveringssysteem is milliseconde-latency niet relevant. Een dagelijkse foto van het volume is voldoende. Je wilt weten hoe de groei evolueert en of die groei aansluit bij het verwachte patroon. Maar je hoeft niet continu te meten of een bestand nu binnen 10 of 20 milliseconden is weggeschreven. Daar ligt niemand wakker van."

Deze context bepaalt welke metrics relevant zijn per resource-type. Voor actieve applicaties tijdens kantooruren wil je bijvoorbeeld weten of er voldoende CPU-resources zijn. Je monitort de gemiddelde belasting, pieken en trends. Hetzelfde geldt voor geheugenconsumptie en netwerkgedrag. Bij databases voeg je query-performance en het aantal actieve gebruikers toe.

Een praktisch voorbeeld: stel dat je CPU boven 80% blijft gedurende meer dan 5 minuten. Dan wil je een waarschuwing. Maar hier komt een cruciale nuance: samenwerking met je applicatieteam is essentieel. Sommige pieken zijn volkomen normaal. Een batch-proces dat data verwerkt mag de CPU naar 100% duwen voor een half uur. Als de business ermee kan leven dat die verwerking zolang duurt, hoef je daar geen extra resources tegenaan te gooien.

Dit onderscheid tussen normale operatie en daadwerkelijke problemen voorkomt dat je team alert fatigue ontwikkelt. Organisaties ontvangen gemiddeld meer dan 1.000 cloud alerts per dag, met 22% die zelfs meer dan 10.000 alerts ontvangt (CloudHealth Technologies, 2023). Het definiëren van je baseline, wat normaal is voor jouw specifieke situatie, houdt dit volume beheersbaar.

De sleutel is begrijpen wat je solution doet voordat je begint te meten. Breng niet alleen de directe applicatie in kaart, maar de volledige ketting van dependencies. Waar haalt je applicatie data vandaan? Waar schrijft ze naartoe? Welke externe services worden aangeroepen? Dit complete plaatje bepaalt welke infrastructuur-metrics je nodig hebt om daadwerkelijk grip te krijgen op wat er gebeurt.

Stap 3: Pas de gouden regel toe - scheid je logging van je applicatie-resources

Een van de meest kritieke architectuurprincipes voor observability ligt vast: schrijf nooit logs weg in dezelfde database die je applicatie gebruikt. Deze regel lijkt vanzelfsprekend, maar in de praktijk zien we regelmatig legacy-systemen waarbij logging en applicatiedata door elkaar lopen.

Het probleem wordt duidelijk bij een incident. Filip beschrijft het scenario: "Stel je hebt een loop in je code die extra belasting veroorzaakt op je database. Je logging-proces gaat ook extra data wegschrijven vanwege die loop. Hierdoor leg je nóg meer belasting op diezelfde database. Het resultaat is een vicieuze cirkel: meer load veroorzaakt meer logs, die weer meer load veroorzaken, tot de hele omgeving crasht. En dan kun je niet eens meer achterhalen wat er gebeurd is, omdat je logging-systeem ook plat ligt."

De moderne aanpak gebruikt dedicated logging-oplossingen. Denk aan Azure Log Analytics voor .NET-omgevingen of Prometheus met Grafana voor Java-stacks. Het principe blijft hetzelfde: je logging-infrastructuur moet gescheiden zijn van je applicatie-resources. Zo min mogelijk impact op elkaar, vooral tijdens calamiteiten wanneer je je logging het meest nodig hebt.

Deze scheiding heeft ook directe impact op je kosten. Als je strategisch bepaalt wat je logt en hoe vaak, kun je 60 tot 80% van je logging-kosten besparen (CNCF Observability Trends, maart 2025). De sleutel ligt in je sample-strategie. Niet alles hoeft seconde-voor-seconde gemeten te worden.

Filip legt uit: "Het verschil tussen samples per seconde versus per minuut is een factor 60 in volume en dus in kosten. Voor veel metrics is een sample per minuut meer dan voldoende. Je moet je afvragen: wat voegt die extra granulariteit toe? Als je applicatie stabiel draait, heb je die secondendata niet nodig. Bewaar die frequentie voor kritieke componenten waar milliseconden ertoe doen."

Deze afweging tussen granulariteit en kosten is een balans-oefening. Cloud-providers rekenen per volume. Google Cloud Observability, AWS CloudWatch en Azure Monitor hebben allemaal volume-gebaseerde pricing. Zonder strategie lopen die kosten snel op. Organisaties kunnen hun cloud observability-uitgaven terugbrengen door slim te samplen en alleen relevante data te bewaren in hot storage, terwijl minder kritieke historische data naar goedkopere cold storage gaat.

Stap 4: Bepaal thresholds en alerts op basis van business-context

Het definiëren van wanneer een metric een waarschuwing moet geven is geen technische oefening, maar een business-beslissing. Het onderscheid tussen wat normaal, waarschuwend of kritiek is vereist nauwe samenwerking met je applicatieteam. Zij begrijpen de business-logica en weten wat acceptabel is.

Filip benadrukt dit punt: "Je moet met je applicatieteam afstemmen wat de verwachtingen zijn van de performance in relatie tot de resources. Een batch die data verwerkt mag de CPU naar 100% duwen. Als dat een half uur of zelfs een paar uur duurt en de business kan ermee leven dat die verwerking zolang duurt, dan is dat prima. Dan hoef je daar niet extra resources tegenaan te gooien. Het gaat om de kost-baten analyse."

Voor infrastructuur-metrics bestaan frameworks die je op weg helpen met standaard thresholds. Denk aan CPU-gebruik boven 80% voor langer dan 5 minuten, of geheugen dat richting 90% gaat. Maar voor applicatie-specifieke logica moet je zelf de relevantie bepalen. Wat betekent het als een bepaalde query langer dan X seconden duurt? Wat is het effect op de gebruikerservaring? Wanneer is het echt een probleem?

Deze contextuele aanpak is cruciaal omdat alert fatigue een reëel probleem vormt. Organisaties ontvangen gemiddeld meer dan 1.000 alerts per dag, waarbij 63% van die organisaties dit volume overschrijdt (CloudHealth Technologies, 2023). Nog schrijnender: teams negeren 67% van de 4.484 dagelijkse alerts door false positives en ruis (LogicMonitor, 2025). Het resultaat is dat 55% van de teams kritieke alerts mist door ineffectieve prioritering.

De oplossing ligt in het zorgvuldig definiëren van wat een alert rechtvaardigt. Niet elke afwijking vereist menselijke interventie. Bepaalde patronen zijn voorspelbaar en normaal. Een webshop die tijdens Black Friday meer load ziet hoeft daarover geen critical alert te genereren als de infrastructuur daar op gedimensioneerd is.

Het doel moet zijn: alleen alerts die daadwerkelijk actie vereisen. Dit betekent onderscheid maken tussen informatie (dit gebeurt), waarschuwing (dit ontwikkelt zich verkeerd) en kritiek (er moet nu ingegrepen worden). Door deze niveaus helder te definiëren met input van zowel technisch als business-perspectief, houd je alerts bruikbaar en voorkom je dat je team de aandacht verliest.

Stap 5: Voorkom dashboard-moeheid door focus op bruikbare inzichten

Het bekendste symptoom van slechte observability is een dashboard dat niemand bekijkt. Organisaties bouwen uitgebreide visualisaties vol grafieken en metrics, maar teams negeren ze omdat er te veel data is zonder duidelijke verhalen of actiepunten.

Filip beschrijft de juiste volgorde: "Metrics verzamelen is pas stap één. Je moet eerst goed begrijpen wat je wilt queryen en visualiseren voordat je een dashboard bouwt. Het gaat erom correlaties te leggen tussen verschillende databronnen zodat je daadwerkelijk inzichten krijgt. Een dashboard is het laatste stuk, niet het eerste."

Dit betekent concreet dat je bepaalt welke vragen je wilt kunnen beantwoorden. Waarom draait een applicatie langzaam? Welke component veroorzaakt de vertraging? Is het de database, de API of de frontend? Een effectief dashboard toont deze correlaties in één oogopslag in plaats van losse metrics die je zelf moet combineren.

Voor organisaties met hybride architecturen waarbij sommige componenten on-premise draaien en andere in de cloud, komt een extra overweging bij: niet alles hoeft centraal verzameld te worden. Filip legt uit: "Je gaat niet continu logdata van on-premise naar de cloud kopiëren. Dat wordt snel duur. Een betere aanpak is een high-level overview centraal houden en pas bij calamiteiten een drill-down doen naar de detail-data die lokaal blijft staan."

Deze gedecentraliseerde benadering voorkomt kostenoverschrijdingen terwijl je toch het overzicht houdt. Platform engineering-modellen tonen aan dat deze aanpak werkt: 87% van organisaties gebruikt een gecentraliseerd observability-team dat meerdere applicatieteams ondersteunt (Logz report via CNCF, 2025). Dit team zorgt voor gestandaardiseerde dashboards met relevante metrics per team, zonder dat elk team zijn eigen monitoring-stack moet uitvinden.

De tool-keuze hangt af van je technologische context. Voor Java-omgevingen zie je vaak Prometheus met Grafana. Voor .NET-stacks is Azure Log Analytics een logische keuze. Belangrijker dan de specifieke tool is dat je kiest voor consolidatie. De trend beweegt duidelijk van 10+ losse monitoring-tools naar geïntegreerde platforms (Middleware Observability Trends, 2024). Dit reduceert de cognitieve overhead voor je teams die anders constant tussen systemen moeten schakelen.

Het bewijs dat deze aanpak werkt is meetbaar: 75% van organisaties gebruikt open source observability-tools zoals Prometheus en OpenTelemetry (Grafana Labs, maart 2025). Deze tools bieden standaardisatie zonder vendor lock-in, wat helpt om dashboards relevant te houden wanneer je infrastructuur evolueert.

Stap 6: Bouw observability by design in vanaf dag één

De grootste fout die organisaties maken met observability is het als nagedachte behandelen. Je bouwt eerst de applicatie, zet alles in productie en probeert daarna pas te bedenken hoe je het gaat monitoren. Filip is hier helder over: "Observability mag geen afterthought zijn. Bij nieuwe ontwikkeling moet het vanaf dag één onderdeel zijn van het design."

Voor nieuwe projecten betekent dit concreet dat je development teams vanaf het begin nadenken over welke metrics relevant zijn, hoe logging gestructureerd wordt en welke verbindingen er gelegd moeten worden met je observability-platform. Bij moderne containerized applicaties zie je vaak sidecar containers die specifiek voor logging en monitoring ingezet worden, gekoppeld aan je applicatie-container. Deze aanpak maakt observability een standaard component in plaats van een externe toevoeging.

Het voordeel van deze by-design benadering wordt zichtbaar in de cijfers. Europa leidt wereldwijd in observability-deployment: 46% van Europese organisaties heeft 10 of meer observability-capabilities geïmplementeerd, vergeleken met 37% wereldwijd (New Relic Europe Report, 2024). Van deze organisaties heeft 32% full-stack observability bereikt versus 25% globaal. Deze voorsprong komt deels door bewuste architectuurkeuzes waarbij monitoring vanaf het begin is ingebouwd.

De return on investment is significant. Organisaties met volledige observability ervaren 79% minder downtime per jaar en besparen gemiddeld 42 miljoen dollar jaarlijks (2024 Observability Forecast). Dit komt omdat problemen vroeg gedetecteerd worden, vaak voordat gebruikers impact ervaren.

Voor bestaande systemen ligt de uitdaging anders. Je kunt niet zomaar alles stoppen en herbouwen. Filip erkent dit: "Bij legacy organisaties is het een tijdrovende maar noodzakelijke oefening. Je moet iteratief werken, stap voor stap observability toevoegen zonder de lopende operatie te verstoren."

De praktische aanpak hier is standaardisatie introduceren via herbruikbare modules of plugins die je overal kunt inbouwen. In plaats van voor elke applicatie opnieuw uit te vinden hoe logging werkt, bouw je templates die development teams kunnen overnemen. Dit versnelt adoptie en zorgt voor consistentie. De applicatie krijgt automatisch de juiste logging en metrics zonder dat het team daar zelf alles voor moet opzetten.

Het eindresultaat moet zijn dat observability een natuurlijk onderdeel wordt van je development flow. Niet als extra stap die tijd kost, maar als geïntegreerde capability die development teams helpt om sneller problemen te vinden en op te lossen.

Stap 7: Denk aan compliance en regelgeving in je strategie

Observability in Europa verschilt fundamenteel van andere regio's door de strikte regelgeving. DORA, NIS2, GDPR en de EU AI Act bepalen niet alleen welke data je moet loggen, maar ook hoe lang je die moet bewaren en hoe je ermee omgaat. Voor veel organisaties zijn deze regulatory vereisten de primaire drijfveer achter observability-investeringen: 43% van Europese bedrijven noemt data security en governance als hoofdreden (New Relic Europe, 2024).

Filip benadrukt de verschuiving in terminologie: "We spreken vandaag niet meer van DevOps maar van DevSecOps. Security moet er by default in zitten. Afhankelijk van je sector worden bepaalde voorwaarden vanuit regulatory perspectief gewoon afgedwongen. Als je dat niet beantwoordt, stel je jezelf bloot aan mogelijke boetes."

Concrete voorbeelden maken dit tastbaar. Bepaalde logs moeten drie tot zes maanden bewaard worden, afhankelijk van je sector. Financiële instellingen vallen onder DORA en hebben strengere eisen dan bijvoorbeeld een webshop. Kritieke infrastructuur valt onder NIS2 met real-time monitoring-verplichtingen. Deze regelgeving dwingt organisaties om observability serieus te nemen, maar creëert tegelijk uitdagingen in kostenbeheer.

De balans tussen compliance-eisen en kosten-efficiëntie vraagt om een doordachte storage-strategie. Niet alle logs hebben dezelfde toegankelijkheid nodig. Recent data waarbij je snel moet kunnen zoeken en analyseren bewaar je in hot storage. Oudere logs die je alleen voor audits nodig hebt kunnen naar goedkopere cold storage. Deze gelaagde aanpak helpt om aan regelgeving te voldoen zonder onnodige kosten.

Europa's regulatory pressure is de sterkste wereldwijd (IDC MarketScape, april 2025), wat verklaart waarom Europese organisaties het verst zijn in observability-maturity. De strenge eisen dwingen tot systematische aanpak en gedegen implementatie. Voor organisaties die hier actief zijn betekent dit dat observability geen nice-to-have is maar een compliance-vereiste.

Het positieve effect is dat deze regelgeving organisaties dwingt om de juiste dingen te doen. Real-time monitoring, gestructureerde logging en incident response capabilities die DORA en NIS2 vereisen zijn precies wat je nodig hebt voor effectieve observability. Compliance wordt zo een driver voor betere IT-praktijken in plaats van alleen een kostenpost.

Conclusie

Effectieve observability draait niet om meer data verzamelen, maar om de juiste data op het juiste moment met bruikbare inzichten. De zeven stappen in deze blog tonen hoe je strategisch opbouwt: begin met het begrijpen van het verschil tussen monitoring en observability, start met infrastructuur-metrics, scheid je logging van applicatie-resources, bepaal thresholds op basis van business-context, voorkom dashboard-moeheid, bouw observability by design in en houd rekening met compliance.

Door deze methodiek toe te passen krijg je eindelijk grip op wat er écht gebeurt in je applicaties. Je team verdrinkt niet langer in duizenden alerts per dag waarvan het merendeel irrelevant is. Je cloud-kosten blijven onder controle in plaats van ongecontroleerd op te lopen. En je voldoet aan regulatory vereisten zonder dat het een bureaucratische nachtmerrie wordt.

Wil je weten hoe Elmos je helpt bij het opzetten van effectieve observability zonder de overhead? Neem contact op voor een vrijblijvend gesprek over jouw specifieke situatie en ontdek hoe onze DevOps-expertise jouw monitoring naar een hoger niveau tilt.